必赢中国官方网站计算机学院刘菊华教授线上讲座“大模型研究进展与思考”顺利举办

点击次数: 更新时间:2023-10-14

本网讯(通讯员 鲁彦君) 10月11日晚,必赢中国官方网站计算机学院刘菊华教授应陈波教授邀请,为大家带来“大模型研究进展与思考”的线上讲座。讲座由程勇教授主持,必赢中国官方网站计算机学院武宇教授评议。来自国内外的600余名听众参与本次线上讲座。

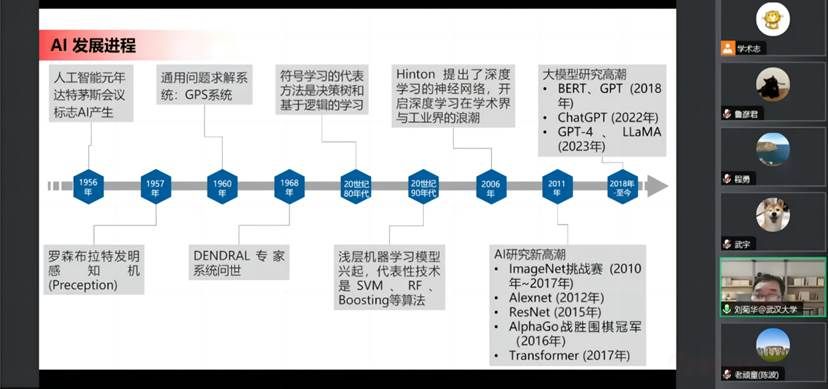

刘菊华教授首先深入浅出地回顾了语言、视觉和多模态大模型历史和发展现状。大模型是新一轮人工智能(artificial intelligence,以下简称AI)热潮的焦点,它是通用人工智能的基础模型,具备场景通用、泛化能力强、可规模化复制等优势。大模型的参数规模远超传统小模型,后者针对特定任务来搜集数据和训练模型,因此存在数据标注成本高、模型容量小、模型泛化性差、应用场景受限等问题,大模型通过“高质量数据集构建—大规模预训练—指令微调—基于人类反馈的强化学习—模型轻量化部署”这一新训练范式弥补了上述不足。在大模型智能程度达到了人类所需智能程度的前提下,大模型可以实现通过个人化助手带来多模态自然交互、精准意图识别等体验,助力医学诊断等重要应用。

经典大模型包括:(1)语言大模型BERT基于Encoder-only构架,采用掩码语言建模和下一句子是否连续预测进行训练,擅长文本理解;(2)语言大模型GPT则是基于Decoder-only构架,通过给出一段文本让模型预测下一个文本进行训练,擅长文本生成;(3)视觉大模型Vison Transformer参考了NLP的Transformer结构,直接将图像转化成自然语言中的token序列进行后续处理,为解决直接对图像进行分块而造成的图像分辨率下降严重、缺少多尺度特征等不足,后续又推出了Swin Transformer模型。

必赢中国官方网站计算机学院团队和京东探索研究院合作提出ViTAE Transformer模型,该模型通过结合CNN(卷积神经网络)和Transformer的优势,在引入CNN的局部性和尺度不变性的同时保持Transformer的全局性。后续基于该模型又推出了ViTAEv2 Transformer,其通过将全局MHSA窗口化加速计算,不需要循环窗口操作和相对位置编码,类CNN分层设计使得模型便于迁移大多种下游任务。这两个模型都在ImageNet数据集上表现了出色的分类性能。未来团队将通过引入Swin Transformer特点来进一步优化模型。

除此之外,因为我们真实生活的环境是一个多模态环境,将各种模态融合而训练出的大模型才是AI的真正目标,因此越来越多的人也将目光转向了多模态大模型,典型的多模态大模型包括CLIP和BEiT-3,BEiT-3提出后,学界内提出了“多模态大一统”概念。

其后,刘菊华教授介绍了必赢中国官方网站计算机学院智能感知与机器学习组所取得的一些研究进展。在语言大模型领域,学习组提出了基于编码增强的自监督预训练方法、基于语义一致Token Dropping的预训练方法和基于知识蒸馏的高效率prompt微调方法等代表性方法。在此基础上,刘菊华教授团队联合京东探索研究所推出了织女大模型v1和织女大模型v2,通过下游迁移学习,织女模型能够广泛应用于语法纠错、文本匹配、常识推理等多种下游自然语言处理任务,同时接连刷新自然语言理解技术世界记录,分别在全球自然语言处理领域顶级测试GLUE和国际权威复杂语言理解任务SuperGLUE评测中荣登榜首,超越了Google、Facebook等国际顶尖机构。

在遥感大模型领域,最大的难题在于缺乏像ImageNet这样的大规模有标注数据集。2021年夏桂松团队做出了一个迄今为止规模最大的遥感场景标注数据集MillionAID,杜博、张良培教授团队基于这一数据库训练的大规模遥感视觉基础模型,于2023年阿里云天池建筑物识别长期赛和“中科星图杯”国际高分遥感解译比赛中均位居榜首,由此受到了广泛关注报道,入选2022年京东集团年度高光盘点,现已被遥感影像智能解译深度学习开源框架LuojiaNet收录。

最后,刘菊华教授对大模型中存在的风险和伦理问题进行了初步探讨。大模型目前主要面临以下四个问题:(1)幻觉问题:输出结果是看似符合逻辑,但实际上却是错误的或不存在的虚假事实,这一问题的解决有赖于幻觉评估与去除、可控生成成本等;(2)隐私保护问题:大模型可能存储敏感信息,导致隐私泄露、未授权访问等隐私安全问题,需要通过隐私数据检测与去除、隐私计算技术等来解决;(3)价值观问题:大模型可能输出违法有害内容,隐含对某些人类社群的偏见和歧视,违反人类和社会价值观,因此需要基于人类反馈的强化学习对齐人类社会价值观;(4)大模型部署:大模型的参数规模过大,导致大模型在端侧推理速度慢,计算资源消耗大,边缘部署困难,云端协同、模型轻量化等方法是突破的关键。

基于南方科技大学计算机科学与工程系姚新教授团队发表的“An Overview of Artificial Intelligence Ethics”一文,刘菊华教授进一步对以上技术问题做出了三个层面的讨论:在个人层面,AI会对个人的安全、隐私、自主和人格尊严等方面产生影响,例如一些AI系统会默认黑人具有更严重的犯罪倾向;其二是社会层面,AI会对社会以及世界各地区和国家的福祉带来广泛影响,例如当AI被非法使用并造成不良社会后果时,由于AI作为技术一般不被视为责任主体,因此关于事故责任主体(工程师、技术使用者或其他主体)的界定就成为问题;其三是环境层面,AI发展会引起自然资源消耗、环境污染、能源消耗成本和可持续性等问题,例如模型训练需要大量耗电。

在评议环节,程勇教授对本讲内容进行了简要总结,随后武宇教授从原理、发展和应用三个角度,就“大模型中知识何以涌现”“团队在标准榜单上取得优秀成绩的经验”“在大多数企业争相推出基于LLaMa大模型的情况下,为避免资源浪费,应如何实现产业内资源整合”“是否存在更好的方式来避免幻觉问题等技术不足”等问题进行提问。

刘菊华教授做出回应,首先他将大模型和参数分别类比为人的大脑和神经元,认为当模型参数规模达到一定程度时,模型的推理过程就能近似于人类大脑的思维方式,如果这种类比成立,那么尽管设计的“神经元”和生物意义上的神经元稍有不同,但在参数规模已超过人脑神经元数量的情况下,出现知识涌现是可以理解的。其次,他谦虚且严谨地表示,团队能以较少参数量的大模型实现比Google等公司开发模型更好的性能,关键原因在于后者通用性更强,而前者是针对特定任务来训练的。再次,过多企业在相同路径下进行研究确实存在重复开发、资源浪费等问题,但是从多样性角度出发,只有从事这一领域的专业人才越多,才有可能将这一领域建设得更好,回顾AI发展历史,可以清楚地看到出现AI浪潮的重要原因就是从事相关研究的人和产业非常多,而相比于此,一个更大的问题则是大模型的评价问题。最后,他指出仅凭计算机科学家无法完全解决幻觉问题,因为只有相关领域专家介入,才能给知识真伪以恰当判断。

最后,线上观众对“计算机科学家如何掌握和运行10万亿级别的参数”进行了提问,刘菊华教授表示目前大模型还存在很多争议,例如增大参数量后,输出结果有时是一本正经的胡说八道,其原因在于现在的大模型类似于黑盒,科学家无法对相关参数进行解释,也因此促使学界强调构建“可信人工智能(Trustworthy AI)”。“黑盒之谜”的解决需要更多数学家和神经科学家的加入,尤其是关于大脑神经元运作机制问题的解决可能是解决当下AI发展潜在瓶颈的钥匙。

(编辑:邓莉萍 审稿:严璨)